Künstliche Intelligenz in der Fotografie: Hype oder Hoffnungsträger?

KI ist das Buzzword seit der letzten photokina und taucht mittlerweile immer häufiger in Branchen-Ankündigungen auf. Was ist dran am Hype? digit! Autorin Petra Vogt erläutert die Funktionsweise und zeigt Einsatzbeispiele, damit Fotografen die Möglichkeiten gezielter nutzen und die Grenzen erkennen können.

Hand aufs Herz: Verwenden Sie künstliche Intelligenz (KI) schon irgendwo in Ihrem Foto-Workflow? Wenn Sie jetzt den Kopf schütteln: Wir wetten, dass es die meisten tun, denn Adobe hat bereits seit einiger Zeit mehrere Funktionen in Photoshop eingebaut, die auf der hauseigenen KI-Technologie Sensei basieren. Auch der in spiegellosen Systemkameras bereits seit Jahren angebotene AF-Modus mit Gesichtserkennung basiert ebenso auf KI wie der Augen-AF von Sony.

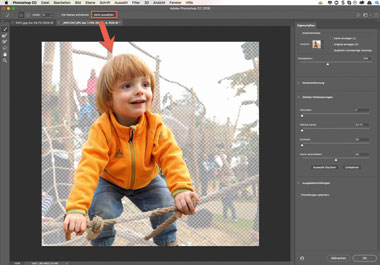

Mithilfe von verschlagworteten Datensätzen lernen neuronale Netze verschiedene Fotos verschiedenen Begriffen zuzuordnen. Eine sehr häufig eingesetzte Bild-Datenbank ist das hier gezeigte Imagenet, das vom Standford Vision Lab bereitgestellt wird.

Diese Beispiele illustrieren, dass sich KI ohne viel Aufhebens bereits in die Fotografie eingeschlichen hat: in die Bildbearbeitung ebenso wie in Kameras und Smartphones. Man hat bisher nur nicht so viel Aufhebens darum gemacht. Erst seit die Smartphone-Hersteller massiv mit KI-Kameras werben, rückt die Technologie mehr in den Blickpunkt. KI ist zu einem Schlagwort geworden, unter dem alles Mögliche – und teilweise auch Unmögliche – rund um die automatisierte Datenverarbeitung subsumiert wird. Daher zunächst einmal eine Standortbestimmung.

Was versteht man eigentlich unter „KI“?

KI (im englischen Artificial Intelligence [AI]) ist ein Oberbegriff für ein Teilgebiet der Informatik und wird übrigens schon seit den 1950er-Jahren erforscht. Die Verbindung zur Fotografie ist enger, als man zunächst vermuten würde, denn das virtuelle „Sehen“ ist eine sehr wichtige Basis-Technologie etwa für selbstfahrende Autos und in der Industrie. Experten verwenden den Begriff KI jedoch gar nicht gerne für die heutigen Technologien, denn er assoziiert viel mehr, als derzeit geleistet wird. Von virtuellen Albert Einsteins oder der automatischen „Motivklingel“ sind nämlich selbst die allermodernsten universitären Computersysteme noch weit entfernt.

Es wurde daher die Unterscheidung in starke bzw. generalisierte KI auf der einen Seite und schwache bzw. spezialisierte auf der anderen eingeführt. Die Zusatzbegriffe illustrieren, worum es geht: Bei spezialisierter KI soll ein isoliertes Teilgebiet menschlichen Vermögens, z. B. das Identifizieren von Motivbestandteilen auf einem Foto, mit Computer-Methoden möglichst gut nachgebildet werden. Dieser Bereich hat in den letzten Jahren dank deutlich gestiegener Hardware-Kapazitäten und den immer leichter verfügbaren großen Datenmengen einen Boom erlebt und lässt manche glauben, es seien kurzfristig wahre Wunder möglich. Von der vollständigen „intelligenten“ Automatisierung der Fotografie und einer Ersetzbarkeit professioneller Fotografen kann aber trotzdem nicht die Rede sein – weder derzeit noch am Horizont. Gleiches gilt übrigens für starke bzw. generalisierte KI und ihre Gleichwertigkeit zu Menschen.

Wie funktioniert KI?

Schauen wir uns die Funktionsweise von KI-Systemen genauer an, um die derzeitigen Möglichkeiten und Grenzen besser zu verstehen: Die aktuell in der maschinellen Bildverarbeitung beliebtesten Methoden kommen aus dem Bereich des „maschinellen Lernens“. Dieses funktioniert ganz ähnlich wie menschliches Lernen und ist für viele von uns im Zusammenhang mit Computern und Kameras neu. Bisher haben wir vor allem mit Systemen zu tun gehabt, die klaren Handlungsanweisungen ihrer Schöpfer folgten. Wenn man z. B. ein Motivprogramm Portrait einstellt, dann aktiviert die Kamera z. B. eine offene Blende und einen Autofokus mit Gesichtserkennung, und zwar immer auf die gleiche Weise, weil ihr Programmierer es genau so festgelegt hat.

Die neuen KI-Programmem, auch „neuronale Netze“ genannt, entwickeln sich dagegen dynamisch und lernen durch Versuch und Irrtum. Für die Bilderkennung bedeutet das zum Beispiel konkret, dass man einem zukünftig „intelligenten“ System zur Erkennung von Hunden zunächst zahllose Bilder von Hunden und anderen Tieren vorlegt. Am Anfang bestimmt alleine der Zufall, ob das Programm einen Hund richtig erkennt. Da es aber jedes Mal Feedback bekommt, ob es richtig gelegen hat, wird seine Einschätzung mit der Zeit immer besser. Hier liegt aber auch schon der erste Knackpunkt: Die Vielfalt und Verschlagwortung der „Lernbilder“ ist ganz entscheidend für die Qualität der Ergebnisse und daher ein sehr wichtiger „Rohstoff“ für die Anbieter von KI. Später noch mehr dazu, wo das relevant für uns Fotografen ist.

Weil Computersysteme nicht ermüden und rund um die Uhr arbeiten, können sie in vergleichsweise kurzer Zeit ein rapides Lernpensum absolvieren. Weiter verbessert und beschleunigt wird dieser Prozess durch die Verschaltung mehrerer solcher neuronaler Netze, die dann „deep neural networks“ genannt werden. Sie sorgten in den letzten Jahren für einen rapiden Fortschritt vor allem in der Bilderkennung. Lag die Trefferquote für die Erkennung von einzelnen Objekten (z. B. „Mensch“, „Hund“) im Rahmen des größten Forschungs-Wettbewerbs im Jahr 2013 noch nur bei 22,5 Prozent, waren es im nächsten Jahr schon 44 Prozent und 2017 lagen die Fehlerquoten schon unterhalb derer des Menschen – wohlbemerkt am Testdatensatz. In der Praxis und vor allem bei heute schon kommerziell erhältlichen Werkzeugen sieht das im Detail noch nicht ganz so brillant aus.

Dies gilt auch für die Erkennung komplexer Szenen wie etwa „Mensch führt Hund am Strand spazieren“, die eine wichtige Grundlage für komplexere Features sowohl in Kameras wie etwa der eingangs genannte Augen-AF als auch bei der Postproduktion ist. Auf Testdatensätzen ist die Trefferquote schon ziemlich gut, im wirklichen Leben machen Gegenlicht oder ungewöhnliche Perspektiven die Erkennung schon deutlich schwieriger. Allerdings sind die Fortschritte nach wie vor groß und schnell. Selbst Emotionen lassen sich mittlerweile mehr oder weniger zuverlässig automatisiert interpretieren. Auch das ist eine wichtige Basis-Technologie, auf der komplexere Funktionen wie etwa ein automatisches Auslösen beim Lächeln des Hauptmotivs – wie es etwa Sony beim Smile Shutter anbietet – aufbauen. Am Deutschen Forschungszentrum für Künstliche Intelligenz wurde sogar ein Projekt durchgeführt, bei dem Bildern auch Attribute wie „schön“ oder „fröhlich“ automatisch zugewiesen werden konnten.

Wie KI in der Bildverarbeitung hilft

Für Profi-Fotografen bringt die automatische KI-Motiverkennung heute schon in der Postproduktion Vorteile, denn sie kann das Finden und Weiterverarbeiten von Aufnahmen deutlich beschleunigen. Dies gilt nicht nur der eigenen Bilder, sondern auch für Stock-Fotos etwa bei Composings, denn auch diese werden zum Teil schon automatisch verschlagwortet. Dank KI können Basis-Stichworte wie etwa „Menschen, Feier, Frühjahr, blau“ mit Hilfe eines Plug-ins wie Excire bei Lightroom Classic oder beim Asset-Management-System Adobe Experience Manager sogar automatisch eingetragen werden. Worauf man dabei achten muss und wo im Detail die Grenzen liegen, darauf werden wir einem folgenden Teil dieser Artikel-Serie zu KI und Fotografie genauer eingehen.

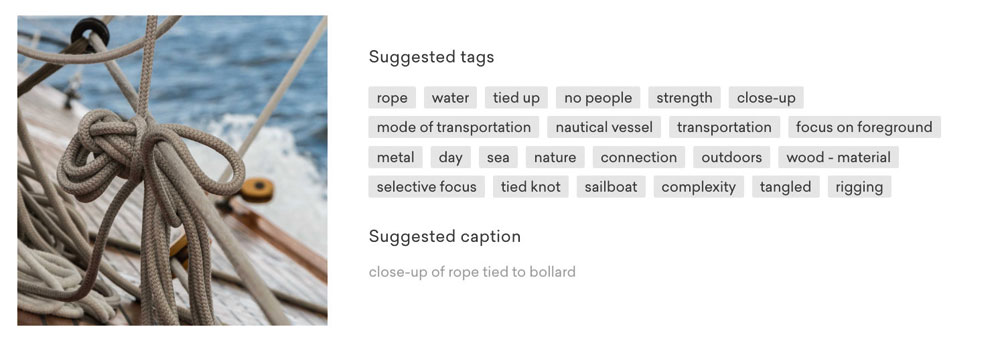

Mit Hilfe von KI können Schlagworte für ein Foto automatisch vergeben werden. Das ist nicht nur für die eigene Festplatte hilfreich, sondern vor allem auch für Stockfoto-Services wie das hier gezeigte EyeEm, wo man zum Testen der Funktion auch eigene Aufnahmen hochladen kann. Foto: Werner Pluta

Wer zur KI noch ein wenig zusätzliche menschliche Intelligenz in seine Archivierung investiert, etwa durch die Benennung einzelner Personen in einem Bild, der kann auch die Verschlagwortung mit Namen für einen größeren Bildbestand vom Computer selbständig erledigen lassen. Theoretisch könnte auch das automatisiert werden, wenn bereits bekannte Wissensbestände wie etwa die der Gesichtserkennung von Facebook mit dem eigenen Bildverarbeitungsprogramm gekoppelt würden. Das ist im Moment aber aus Datenschutz- und Wettbewerbsgründen – je nach eigener Perspektive leider oder zum Glück – (noch) nicht möglich.

KI für Video: Besonders hilfreich kann die automatische Bilderkennung auch im Video-Bereich sein. Aus dem Gesamtmaterial die relevanten Passagen zu extrahieren, verursacht derzeit noch viel Zeit und macht die Videoproduktion aufwändig. Für die Vorselektion springt daher KI mittlerweile in die Bresche. Ein Forschungsbereich von IBM etwa hat aus Aufnahmen von den US-Masters im Golf automatisch die wichtigsten Szenen extrahiert. Gerade für mehr oder weniger standardisierte Abläufe wie beim Sport oder bei Hochzeiten kann KI recht gut eingesetzt werden. Dank Gesichts(wieder)erkennung ist es auch möglich, gezielt Aufnahmen von einer bestimmten Person zu suchen. IBM geht sogar noch weiter und hat für den Langfilm „Morgan“ vom Studio 20th Century Fox einen Trailer vollautomatisch von KI schneiden lassen, der zwar noch nicht ganz die Qualität eines menschlich produzierten hatte, aber schon beachtlich war.

KI in der Bildbearbeitung

KI zieht in der Postproduktion aber nicht nur in die Verschlagwortung und Bildauswahl ein, sondern immer mehr auch in die Bildbearbeitung vom Freistellen über die Retusche bis hin zum Hochskalieren. Auf Einsteiger zielende Anwendungen wie etwa „Photolemur“ oder auch Lightroom CC bieten bereits eine „1-Click-Bildoptimierung“ an und erledigen die typischen leichten Korrekturen von Tiefen und Lichtern sowie der Schärfe von mehr oder weniger ambitionierten Hobby-Fotografen recht ordentlich. Für Profis bringen Spezialprogramme wie PortraitPro die KI in die professionelle Bildbearbeitung. Aber auch Photoshop setzt mittlerweile bei zahlreichen Funktionen auf KI, z. B. beim „intelligenten Füllen“ ebenso wie bei „Motiv auswählen“ und dem Verflüssigen.

Das intelligente Füllen zeigt anschaulich den qualitativen Sprung durch KI in der Bildbearbeitung: Beim früheren inhaltssensitiven Füllen, etwa zur Retusche kleiner Bereiche, ging das Programm nach Mustern und Farben vor – ohne Kenntnis des eigentlichen Motivs. Ob eine kleine braune, gemusterte Stelle ein Stück Hundefell, Perücke oder Erdboden war, spielte für die Software keine Rolle. KI jedoch ermöglicht, ein Bild inhaltlich zu erkennen und in seine semantischen Einzelteile zu zerlegen.

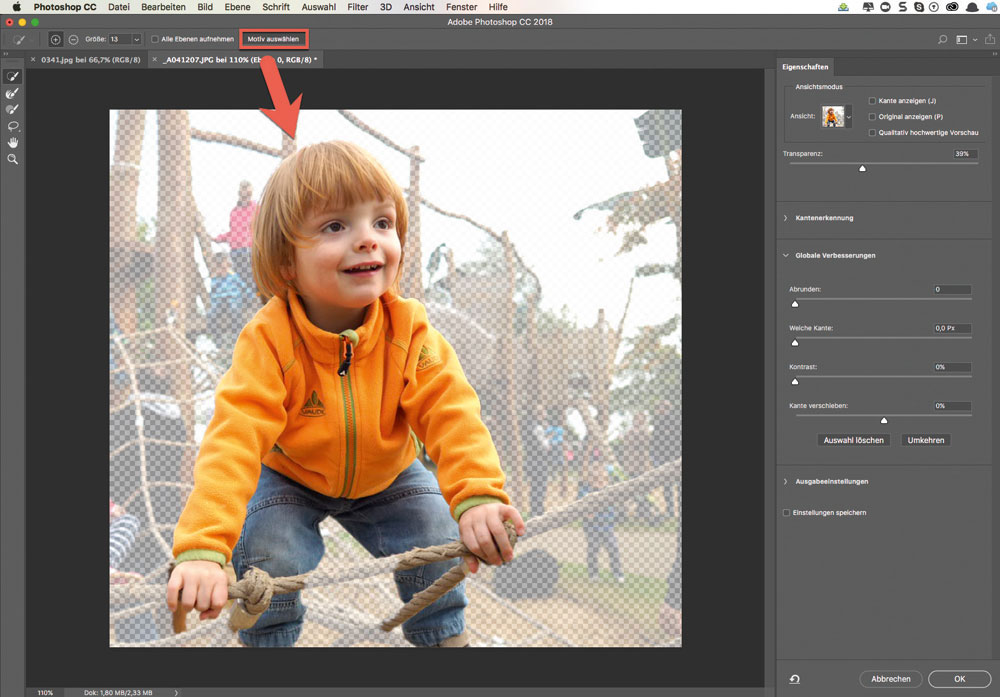

Die unauffällig als Option im Zauberstab versteckte Funktion „Motiv auswählen“ selektiert mit einem Klick das Hauptmotiv einer Aufnahme. Das funktionierte bei Personen und Tieren in unseren Tests schon sehr gut. Einzig bei abstrakten Aufnahmen, wie etwa einem monochromen Tau mit Schärfeverlauf, musste die Funktion passen. Foto: Petra Vogt

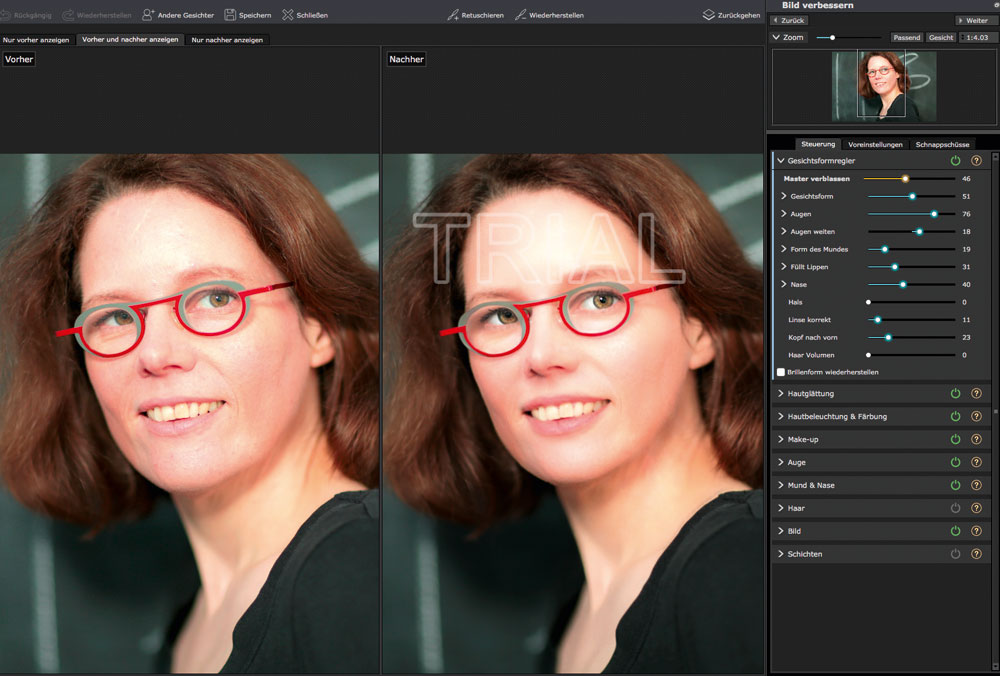

Das funktioniert im aktuellen Photoshop für Personen und selbst Tiere schon überraschend gut – wenn auch meist noch mit kleineren Problemen, etwa bei den Haaren. Eine solche schnelle KI-Selektion macht im nächsten Schritt eine automatische Bearbeitung pro Bildelement möglich: Bei Gesichtshaut von Menschen kann man dann Hautunreinheiten glätten lassen, während die KI sie bei einem gleichfarbigen Pixelbereich einer hautfarbenen Kroko-Tasche unbearbeitet lässt. Es kann sogar noch weiter gehen, sodass z. B. die Gesichter von Frauen stärker geglättet werden als die von Männern — oder genau umgekehrt, wenn sich der Zeitgeschmack ändert. Programme wie PortraitPro von Anthropics setzen eine ausgefeilte KI-Bildbearbeitung bereits sehr umfassend ein und bieten nicht nur die automatische Hautglättung, sondern auch komplette „Beauty-OPs“ inklusive Nasenverschlankung und Korrektur der Gesichtsform. Kurz- bis mittelfristig sind außerdem Programme im Stil eines „virtuellen Foto-Assistenten“ zu erwarten, die vom Fotografen dessen individuellen Bearbeitungsstil selbstständig erlernen und auf neue Bilder anwenden können.

Inwieweit solche Services nur lokal laufen oder ob die Einspeisung in ein größeres KI-System erfolgt und wie sich die Anwendung im zweiten Fall für den Fotografen als geistiges Eigentum schützen lässt, muss noch geklärt werden. Potenziell wäre es sogar eine mögliche Verdienstquelle für Fotografen, ihren eigenen Stil etwa im Sinne eines Plug-ins oder wie Photoshop-Aktionen auch für andere vermarkten zu können. Um die rechtliche Einordnung von KI wird jedoch auf vielen Ebenen derzeit noch gerungen und die Entwicklung ist in der Praxis häufig so schnell, dass sie nicht hinreichend reguliert werden kann. Daher gilt es für den einzelnen Fotografen, genau zu hinterfragen, wo die eigenen Bilder und das eigene Wissen landen, sobald KI und vor allem das Hochladen und Ablegen in der Cloud ins Spiel kommen.

KI in der Kamera

Die gezeigten Einsatzgebiete in der Postproduktion helfen, zu verstehen, welche Vorteile KI in der Kamera bietet: Auf der Basis der Motiverkennung kann man beispielsweise für Einsteiger gezielt Motivprogramme anbieten. Smartphones machen es vor und wechseln etwa im KI-Modus dynamisch von einem Portrait-Programm zum Makro, wenn man die Kamera von einem Menschen zu seiner Armbanduhr schwenkt. Aber auch für Profis nützliche Funktionen wie etwa ein Autofokus, der gezielt auf bestimmte Motiv(teile) scharf stellt, werden möglich. Die bei spiegellosen Systemkameras wie etwa bei Panasonic seit Jahren verfügbaren AF-Modi mit Gesichtserkennung basieren auf KI. Auch ein Augen-Fokus wie etwa der von Sony, der für viel Aufmerksamkeit gesorgt hat und sogar zwischen Menschen und Tieren differenzieren kann, wird erst durch KI möglich.

Olympus bietet bei der E-M1X für Sportfotografen sogar die gezielte Erkennung von Objekten, und zwar zunächst von Flugzeugen, Zügen und Fahrzeugen im Motorsport. Drohnen zeigen, wo die Reise in dem Bereich hingeht: Sie können dynamisch ein Motiv, wie zum Beispiel eine bestimmte Person – sogar innerhalb einer Gruppe –, verfolgen, und zwar nicht nur mit dem Autofokus, sondern gleich mit dem ganzen Gerät. Das vereinfacht das Drehen von Clips mit bewegten Motiven deutlich. Mit den früher verwendeten Autofokus-Methoden des Phasen- oder Kontrast-AF alleine könnte man so etwas nicht bewältigen, denn sie arbeiten unabhängig vom Inhalt und basieren rein auf den Regeln der Optik. Potenziell wären mit KI übrigens rein technisch auch die gezielte Erkennung von urheberrechtlich geschützten Motiven, wie etwa der Eiffelturm-Beleuchtung, und eine Auslöseblockade heute schon möglich – allerdings mit einer gewissen Fehlerquote. Und genau da liegt der Knackpunkt: Selbst bei einer Erkennungsrate von 99 % würde bei 1.000 Fotos statistisch 10 Mal das Auslösen zu Unrecht verweigert. Es ist also wenig wahrscheinlich, dass solche Features mittelfristig in die Kameras einziehen.

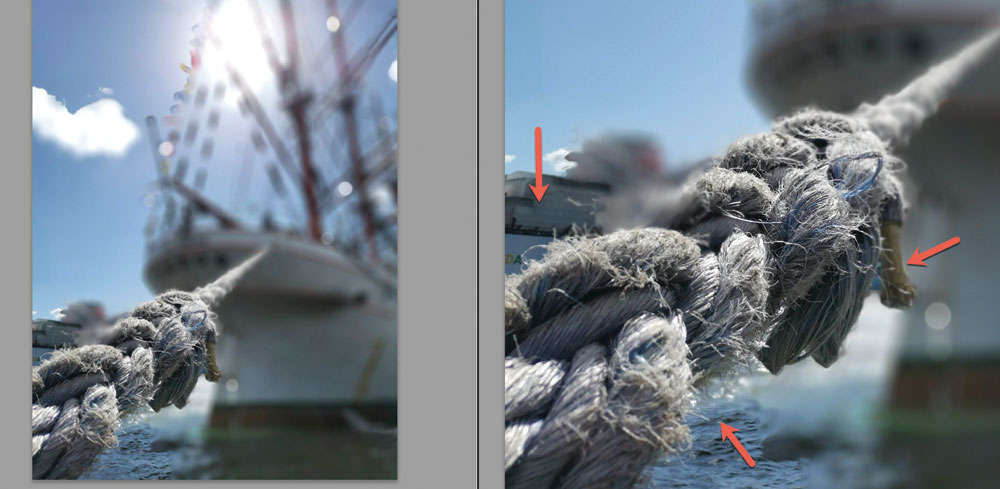

Selbst bei Weitwinkel-Objektiven können moderne Smartphones dank KI einen Schärfeverlauf per Software emulieren. Noch kann man allerdings, wie in unserem Beispielfoto, häufiger mal kleinere Fehler entdecken. Foto: Petra Vogt (mit Huawei P30).

Schon real ist dagegen ein sogenannter „predictive focus“, auch 4D-Fokus genannt, bei dem auf die nächste Position eines Objektes scharf gestellt wird, bevor es überhaupt dort ist – ganz ähnlich wie unser Gehirn beim Überqueren einer Straße automatisch berechnet, ob ein herannahendes Auto noch weit genug entfernt ist und wir unter Umständen beschleunigen müssen, damit wir nicht angefahren werden. Sony und verschiedene Smartphone-Hersteller bieten dies bereits an. Die rapide Entwicklung in der KI dürfte hier schon sehr bald zu einer weiteren deutlichen Verbesserung führen.

Smartphones bleiben aber nicht bei der Optimierung der Aufnahme stehen, sondern gehen noch einen Schritt weiter: Um die Unzulänglichkeiten im Vergleich zu DSLR und Spiegellosen auszugleichen, setzen sie auf die Bearbeitung eines Bildes bereits während der Aufnahme. KI ermöglicht etwa einen Freistellungseffekt durch künstliche Reduktion der Schärfentiefe sogar beim Weitwinkel-Objektiv des Smartphones. Anders als bei konventioneller Software kann KI die Bearbeitung abhängig vom Motiv vornehmen: Möchte man etwa eine Person freistellen, neben der sich im gleichen Abstand ein irrelevantes Objekt (z. B. ein Ast von einem Baum oder eine Türkante) befindet, dann kann man dank KI selektiv nur die gewünschte Person isolieren und den Rest in der Unschärfe verschwimmen lassen. Das ging bisher nur durch sehr aufwändige händische Bildbearbeitung – und nicht für Alltags-Knipser. Noch ist es zwar selbst in modernen Top-Geräten bei einer 100-Prozent-Vergrößerung der Aufnahme häufig fehlerhaft, aber die Fortschritte sind enorm. Ist ein solches Feature in Zukunft in jedes Smartphone eingebaut, werden sich unsere Sehgewohnheiten, die derzeit immer noch stark von den physikalischen Gegebenheiten der fotografischen Optik geprägt sind, deutlich ändern.

Große Vorteile verspricht KI auch für Aufnahmen bei wenig Licht. Schon heute bieten die Algorithmen in Smartphones einen deutlich sichtbaren Vorteil für die Bildstabilisierung, denn die Artefakte durch Bewegungsunschärfe lassen sich mittlerweile durch Rechenoperationen recht gut entfernen. Dies gilt besonders auch für Video-Aufnahmen, wo in einem auch die Verwacklungsunschärfe beim Drehen aus der Hand bis zu einem gewissen Grad herausgerechnet werden kann. Es ist frappierend, zu sehen, wie gut sich mittlerweile mit den KI-Kameras Clips selbst in der Dämmerung stabil aus der Hand drehen lassen, ohne dass man beim Betrachten seekrank wird.

Und das ist laut Experten erst der Anfang. Gerade im Low-Light-Bereich werden enorme Fortschritte durch KI vorhergesagt – die schwer vorstellbar sind, wenn man sich den bereits riesigen Qualitätsunterschied von den rauschigen Ergebnissen auf analogem Film mit 3.200 ASA bis hin zu heutigen 409.600-ISO-Aufnahmen anschaut. Aber erste prototypische Anwendungen existieren bereits und lassen erwarten, dass man in Zukunft selbst bei schummerigem Kerzenlicht noch Details wie Schriftzüge klar erkennen können wird. Der Einsatz eines Stativs wird auch bei extremen Low-Light-Situationen immer seltener erforderlich.

Zusammengefasst lässt sich sagen: KI verschiebt den Fokus beim Equipment von der Hardware auf die Software. Technische Limitierungen und Besonderheiten, wie etwa die typische Verzerrung des Weitwinkels, macht die KI-Software direkt in der Kamera irrelevant – entweder werden sie schon bei der Aufnahme herausgerechnet oder genau im Gegenteil simuliert.

Da ist es nur noch ein kleiner Schritt hin zu deutlicher Bildbearbeitung schon in der Kamera, die bereits bei Smartphones praktiziert wird und in Zukunft vermutlich vor allem im Consumer-Bereich verstärkt auch in Kameras zum Einsatz kommen dürfte. Deutlich meint dabei nicht nur subtile Korrekturen, zum Beispiel der Verzerrung von Objektiven oder die nachträgliche Anwendung von Kunstfiltern, sondern auch die farbliche Anpassung und Glättung der Haut im Portrait-Modus, wie sie bisher erst ein Profi-Programm wie PortraitPro erledigte. Vorreiter ist hier z. B. Panasonic mit seiner GX880, die im Beauty-Modus beispielsweise die Effekte Soft-Skin und Verschlanken (Slimming) anbietet. Sogar der nachträgliche Austausch von kompletten Hintergründen samt Simulation einer Studio-Beleuchtung ist mittlerweile in Smartphones bereits Alltag.

Anders als bei nachträglichen Filter-Funktionen, wie wir sie bereits bei manchen Kameras kennen, wird die KI-Bearbeitung bei den meisten Smartphones übrigens unmittelbar angewendet, und man bekommt keine RAW-Datei – weder zu sehen noch auf der Speicherkarte. Es ist aber zu erwarten, dass dies bei professionellem Equipment anders sein und KI flexibel ein- und ausschaltbar sein wird, denn der Anspruch an professionelle Fotografie ist ja häufig auch ein dokumentarischer. Außerdem sind die Ergebnisse der KI-Bildbearbeitung vor allem bei schwierigen Motivbereichen wie Haaren selbst für Laien noch sichtbar fehlerhaft. Aber wenn die Entwicklung im gleichen Tempo wie bisher voranschreitet, dürfte das schon sehr bald nicht mehr der Fall sein.

Ein entscheidender Treiber dieser Entwicklung sind sogenannte Neural Processing Units (NPU), die sich um die direkte KI-Verarbeitung der Bilddaten im Gerät kümmern. Die früher benötigte Internet-Verbindung zu leistungsfähigen Zentralrechnern mit KI-Funktionen, die immer noch bei preisgünstigeren Smartphones und zum Ersttraining genutzt werden müssen, wird damit im Alltag entbehrlich und macht die KI-Fotografie schneller und unabhängiger. Es ist zu erwarten, dass auch professionelle Kameras eher in diese Hardware-Richtung gehen, als schnelle Internet-Verbindungen einzusetzen, da wir alle wissen, dass Letztere immer noch an vielen Orten nicht stabil und nicht schnell genug verfügbar sind.

Ausblick Fotografie

Es zeichnet sich ab, dass die Wirklichkeit dank KI in weiten Bereichen der Fotografie nur noch der Ausgangspunkt fürs Bild sein wird und die Grenze zur Erschaffung künstlicher Welten fließender. Das kennen wir aus der Profi-Bildbearbeitung schon. Neu ist, dass die Bearbeitung direkt in der Kamera erfolgt und auch Laien ohne Aufwand zugänglich ist. Die Aufnahmen werden also in rein technischer Hinsicht auch ohne große Einarbeitung immer besser und haben auf den ersten Blick einen professionelleren Look. Man sollte sich von den aktuell häufig noch nicht optimalen Ergebnissen nicht täuschen lassen – die KI-Technologie steht noch ganz am Anfang. Für Profis wird es daher noch wichtiger, sich über andere Qualifikationen abzugrenzen. Den Dialog mit einem Porträtierten etwa, um überhaupt ein nettes Ausgangsbild zu bekommen, wird einem auf absehbare Zeit kein Chatbot in der Kamera abnehmen. „Wir Menschen zeichnen uns dadurch aus, dass wir uns in Situationen und in unser Gegenüber hineinversetzen und mögliche Auswirkungen reflektieren können. Der KI ist dieser Bezug nicht bewusst. Das spielt für sie gar keine Rolle“, erläutert Prof. Dr. Andreas Dengel, der Standortleiter am Deutschen Forschungszentrum für Künstliche Intelligenz in Kaiserslautern ist. Er hat auch eine klare Haltung zur möglichen Kreativität von KI: „Menschliche Kreativität kann im Gegensatz zu KI intuitiv Wechselbeziehungen herstellen. Hierbei spielen auch die Persönlichkeit und das soziale Umfeld eine Rolle, also eine ganz andere Form schöpferischer Kraft, die der KI fehlt.“ Damit befindet er sich in der Gesellschaft vieler Forscher, die glauben, dass gerade die menschliche Kreativität im Zeitalter von KI eine immer wichtigere menschliche Domäne wird.

Mit einer Software wie PortraitPro wird mit einem Mausklick aus einem normalen Menschen ein Beauty-Klon – wenn man nicht aufpasst. Foto: Marion Meister

Wer sich die bisherigen Ergebnisse KI-optimierter Bildbearbeitung anschaut, sieht sich bestätigt: Die derzeit moderne deutliche Überschärfung, kombiniert mit etwas HDR, wird gnadenlos auf jedes Bild angewendet. Und es könnte noch extremer kommen, denn KI verstärkt beobachtete Effekte in der Regel schnell und deutlich. Womöglich sehen ganz normale Menschen sehr bald eher einem Beauty-Klon ähnlich als sich selbst. Das könnte kreative Fotografen in eine gute Ausgangsposition bringen, denn möglicherweise wird das wirklich Neue und Künstlerische dann umso wertvoller. Auch könnte die Dokumentarfotografie und mit ihr das Ungeschönte, „Echte“ eine neue Blüte erleben. Wir sehen in anderen Bereichen der Gesellschaft, dass in Zeiten der immer stärkeren Industrialisierung und damit einhergehenden Standardisierung manuelle Tätigkeiten, wie etwa Brotbacken und Gärtnern, ein Revival erleben.

Ausblick für Video

Noch stärker verändern könnte KI den Video-Bereich, denn dort ist KI nicht nur aufs Bild beschränkt. KI-gestützte Services kommen mittlerweile im Schnitt sowie für die Vertonung, Untertitelung und sogar (testweise) für Drehbücher zum Einsatz. Für die Musikuntermalung gibt es mittlerweile spezielle Audioservices wie etwa Amper, die Audio-Clips künstlich durch Software „komponieren“. Da ein solches Programm nur einmal entwickelt werden muss und dann unermüdlich Musik produziert, können solche Services direkt in Videoschnittprogramme integriert werden, wie es bei Amper und Adobe Premiere Pro bereits der Fall ist. Wer an der Qualität von „KI-Musik“ zweifelt, konnte sich auf der Hamburger Ausstellung „Out of Office – wenn KI und Roboter für uns arbeiten“ im Blindtest davon überzeugen, dass es keineswegs einfach ist, vom Menschen gemachteMusik von maschineller zu unterscheiden. Das gilt perspektivisch auch für die Vertonung. Noch sind Computerstimmen zwar in der Regel recht einfach als solche zu erkennen, aber auch hier ist in Forschungslabors schon ein Trend hin zur Natürlichkeit zu hören.

Fazit und Prognose

Die ersten Wellen der Digitalisierung in der Fotografie waren die Umstellung auf die digitale Aufnahme und die digitale Bildbearbeitung, die nächste wird die Unterstützung durch KI im weitesten Sinne sein. Diese wird zunächst vor allem den Consumer-Bereich betreffen, aber genauso wie bei der Digitalfotografie und dem Autofokus auch in die Profi-Welt vordringen und einen festen Platz bekommen – wahrscheinlich neben bestehenden Verfahren. Der Wandel wird ähnlich fundamental sein wie bei der Umstellung auf die Digitalfotografie und hat das Potenzial, die Fotografie auch inhaltlich deutlich zu verändern, so wie es etwa die Mobilität und kürzeren Belichtungszeiten der ersten kompakteren Kameras Ende des 19. Jahrhunderts getan haben.